Seite 1 von 2

GPU-Z

Verfasst: 07.10.2007, 18:27

von Andy_20

Jetzt gibts auch sowas für den GPU:

Guckst du hier!

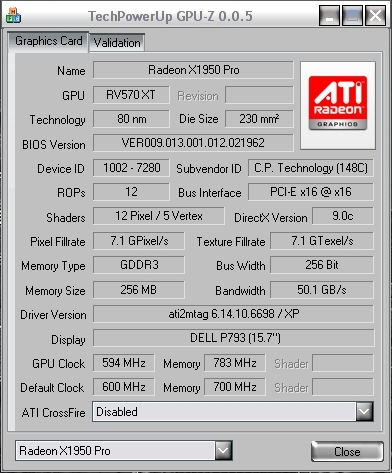

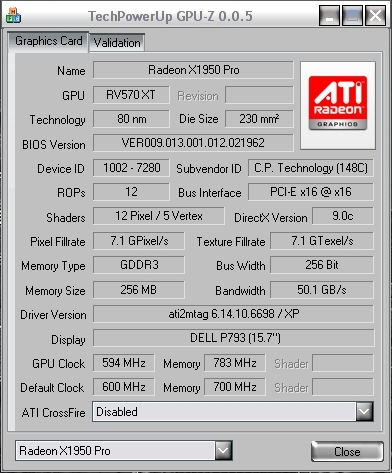

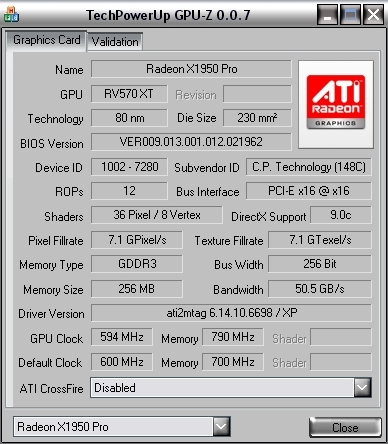

Gleich mal meins angehängt

.

Verfasst: 07.10.2007, 18:35

von psico

jo aber deine Grafikkarte Speicherbandbreite is mal nich korrekt angezeigt. 78 GB/s da liegt ein kleiner auslese fehler vor.^^

aber mal wieder ein kleines hilfreiches tool.

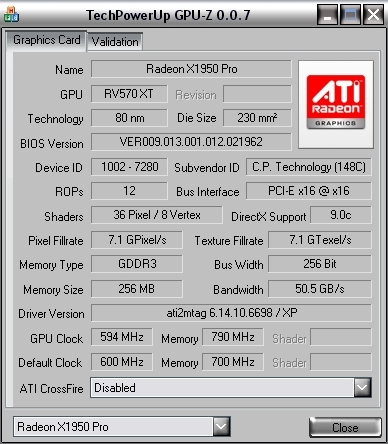

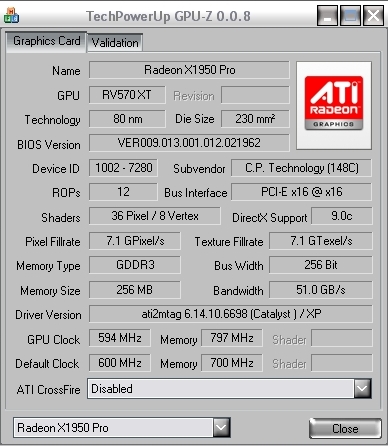

hier ma meine ^^ und wie ich sehe zeigt das tool auch bei ner ati nich alles korrekt an.

Verfasst: 08.10.2007, 14:45

von Sgt.4dr14n

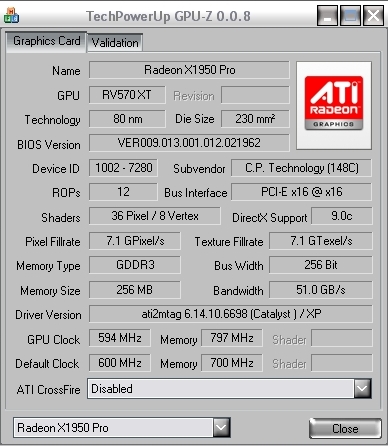

Also bei mir wird auch nicht alles korrekt angezeigt:

Core Takt müsste nämlich bei 628 liegen, außerdem hab ich 36 Pixel- und 8 Vertex-Shader

Verfasst: 08.10.2007, 14:53

von Dackel

Everest Ultimate Edition is noch besser

Hab zwar keine Vergleichsmöglichkeiten, aber bis jetzt hat Everest immer alles richitg ausgelesen...

Verfasst: 08.10.2007, 15:18

von Zuujin

Moin!

Und hier das erste Bild der v0.0.6

Erstaunlich, da kommen die updates ja so schnell wie bei Linuxtools

Grüße,

Zuujin

Verfasst: 08.10.2007, 19:53

von Vulkano

hier mal meine 8600GT mit standart OC

Verfasst: 08.10.2007, 19:59

von Sgt.4dr14n

nett ^^

haste schon weitere OC-Versuche probiert?

Verfasst: 08.10.2007, 20:01

von Vulkano

-.- adrian schau in mein profil dann siehst du es

wobei ich die extreme einstellungen aus dem profil sowohl für CPU alls auch für Grafikkarte nur sehr kurz zum Benchen eingestellt hatte, weil ich die hardware noch etwas länger nutzen möchte

Verfasst: 08.10.2007, 20:04

von Sgt.4dr14n

ja, die Daten waren so aber glaub ich schon früher da, und du hattest ja mal gesagt dass da vllt. noch das eine oder andere MHz rauszuquetschen sei

ps: B²T

EDIT: außerdem will ich nich auf deine P**noseite gehen nur um deine Ergebnisse angucken zu können xD

Verfasst: 08.10.2007, 20:06

von Vulkano

nee mehr geht leider nicht...... sobald ich bei GPU 5 mhz mehr mache kommt bild freeze und sobald ich Ram erhöhe kommen pixel fehler

ich wollte mehr erreichen durch den Volt-Mod an der Karte aber da habe ich dann doch vor gekniffen

vieleicht wenn ich mir eine neue Grafikkarte kaufen möchte dann mach ich den mod

Verfasst: 08.10.2007, 20:27

von soprano

jo passt

Verfasst: 12.10.2007, 17:07

von linkin_park_forever

Hm, 0.0.7 geht bei mir nicht. Das Prog wird zwar im Taskmanager angezeigt, zeigt sich aber sonst nirgendwo.

Verfasst: 13.10.2007, 11:23

von psico

die 0.0.7 zeigt bei meiner ati nun sogar die 36/8 an anstatt 12/6. es entwickelt sich doch langsam.

Verfasst: 13.10.2007, 12:21

von Sgt.4dr14n

Coretakt wird immer noch nicht richtig angezeigt, dafür passt der Rest

EDIT: heisst wohl auf 0.0.8 Morgen warten xD

EDIT2: so 0.0.8 zeigt immernoch falsch an :<

Verfasst: 12.11.2007, 11:39

von DELL

Ist besser wenn ich meine nicht rein stelle

Aber wenn ihr mich hier beraten würdet, dann würde ich meine reinstellen

https://www.pce-forum.de/neu-gk-t20500.html

Verfasst: 12.11.2007, 13:30

von Takato

Hier normal

und so OC

Verfasst: 12.11.2007, 20:27

von Faint

Verfasst: 26.11.2007, 16:23

von Vulkano

was bringt mir eigentlich das übertakten des shader clocks ?? mit dem neuen riva tuner kann ich den auch ganz schön hoch jagen aber was bringt es mir "genau" ?? habe nix in google gefunden

EDIT: ich habe jetz immernoch nix gefunden bei google ausser auf einer seite wo die in einem artikel beschreiben das man bei einer 8800GT den shader clock auf 1850 mhz erhöht haben und dadurch in vielen spielen bis zu 10% mehr leistung erhielten ?? Stimmt das ?? kann der shader clock solch eine auswirkung haben ??

EDIT2: weis niemand rat ?

Verfasst: 02.12.2007, 22:30

von Vulkano

Verfasst: 03.12.2007, 13:45

von Sgt.4dr14n

1. Bilder nicht direkt reinposten (jedenfalls bei der Größe)

2. der Ausschnitt von GPU-Z hätte gereicht